ISSN: 2007-7033 | Núm. 61 | e1576 | Sección abierta: artículos de investigación

Adaptación y validación de una escala

de uso tecnológico docente universitario

Adaptation and validation of a scale of

technological use in superior teacher’s

Gabriel Bernardo López Pérez* Claudia Cecilia Norzagaray-Benítez** Mirsha Alicia Sotelo-Castillo*** José Alberto Fraijo-Figueroa****

La evaluación del uso tecnológico, así como su investigación, es importante para elaborar predicciones sobre aspectos que lo promuevan; por ello, el objetivo de esta investigación es la validación de una escala de uso tecnológico docente a nivel superior. Se empleó una muestra de 69 profesores/as pertenecientes a universidades públicas y privadas del noroeste de México, y se adaptó y validó la escala de Tuapanta et al. (2017). Durante la adaptación del instrumento, se empleó la técnica de traducción inversa y, para la validez de constructo, el análisis factorial exploratorio. Los resultados arrojaron una solución unidimensional, la cual fue sometida a un análisis factorial confirmatorio que constató la estructura con índices de ajuste prácticos y poblacionales adecuados; por último, se analizó la consistencia interna mediante el coeficiente de alpha de Cronbach, que resultó en un puntaje satisfactorio en la escala final. Se concluye que la versión adaptada de la escala es válida y fiable para la evaluación de la realidad del profesorado de nivel superior en México.

Palabras clave:

validación psicométrica, uso tecnológico docente, tecnología educativa, docentes universitarios, educación superior

The evaluation of technological use, as well as its research is important to be able to make predictions about aspects that promote it, therefore, the objective of this research is the validation of a scale of technological use by teachers at a higher level. A sample of 69 teachers belonging to public and private universities in northwestern Mexico was used, and the Tuapanta et al. (2017) scale were adapted and validated. During the adaptation of the instrument, the back-translation technique was used; for construct validity, exploratory factor analysis was used. The results yielded a unidimensional solution which was subjected to a confirmatory factor analysis, which confirmed the structure with adequate practical and population fit indices; finally, internal consistency was analyzed using Cronbach's Alpha coefficient, yielding a satisfactory score on the final scale. It is concluded that the adapted version of the scale is valid and reliable for the evaluation of the reality of higher education teachers in Mexico.

Keywords:

psychometric validation, teacher’s technology use, educational technology, university teachers, superior education

Recibido: 5 de junio de 2023 | Aceptado para su publicación: 15 de noviembre de 2023 |

Publicado: 1 de diciembre de 2023

Cómo citar: López Pérez, G. B., Norzagaray-Benítez, C. C., Sotelo-Castillo, M. A. y Fraijo-Figueroa, J. A. (2023). Adaptación y validación de una escala de uso tecnológico docente universitario.. Sinéctica, Revista Electrónica de Educación, (61), e1576. https://doi.org/10.31391/S2007-7033(2023)0061-015

* Doctorando en Psicología en la Universidad de Sonora. Líneas de investigación: evaluación de profesores(as) de nivel medio superior y superior, uso tecnológico. Correo electrónico: a221130073@unison.mx/https://orcid.org/0000-0002-3082-0961

** Doctora en Educación. Profesora en el Departamento de Psicología y Ciencias de la Comunicación de la Universidad de Sonora. Líneas de investigación: estrategias enseñanza-aprendizaje, orientación educativa y vocacional, evaluación educativa. Correo electrónico: cecilia.norzagaray@unison.mx/https://orcid.org/0000-0003-4695-112X

*** Doctora en Sistemas y Ambientes Educativos. Jefa del Departamento de Psicología del Instituto Tecnológico de Sonora. Líneas de investigación: desarrollo de los estudiantes, evaluación de perfil del profesor(a), aprendizaje, evaluación educativa de cursos en modalidad mixta. Correo electrónico: mirsha.sotelo@itson.edu.mx/https://orcid.org/0000-0001-9838-189X

**** Doctor en Psicología. Docente en el Departamento de Psicología y Ciencias de la Comunicación de la Universidad de Sonora. Líneas de investigación: educación, desarrollo humano, psicología educativa, procesos de aprendizaje. Correo electrónico: jose.fraijo@unison.mx/https://orcid.org/0000-0001-9365-9282

Introducción

La definición de tecnologías de la información y la comunicación (TIC) refiere a dispositivos como computadoras, tabletas, celulares, recursos digitales web, transmisión en vivo y telefonía móvil, de acuerdo con la Organización de las Naciones Unidas para la Educación, la Ciencia y la Cultura (Unesco, 2019); a este concepto se añade la simulación, realidad aumentada, programación, así como aplicaciones para teléfonos inteligentes y robótica (Fonseca, 2005). La Unesco (2016) indica que el alumnado debe conocer y estar familiarizado con dispositivos electrónicos, así como herramientas digitales, y espera que estos aprendizajes sean adquiridos mediante la impartición de un currículo integral, el cual incluya las tecnologías en su aprendizaje (Organización de Estados Iberoamericanos para la Educación, la Ciencia y la Cultura, 2008). Para lograr lo anterior, se ha vuelto prioritario fortalecer la competencia docente para el uso tecnológico (Unesco, 2019), así como que sean capaces de incorporarlas al proceso de enseñanza- aprendizaje (Cabero-Almenara et al. 2020).

La investigación de los procesos que potencian el dominio y uso adecuado de la tecnología es un tema de amplia relevancia (World Economic Forum, 2016), ya que el uso y nivel de integración tecnológica es un indicador de crecimiento en el marco económico del conocimiento; además, se considera que en la cuarta revolución industrial se desarrollarán sistemas ciberfísicos, lo que implica que las personas adquieran capacidades cognitivas para el uso de la infraestructura y tecnologías disponibles, o que, dicho de otra manera, sean competentes digitales, lo cual creará nuevas formas de integración tecnológica en las sociedades (World Economic Forum, 2016).

Estas competencias digitales se componen de tres aspectos (Flores-Lueg y Roig-Vila, 2016; Rangel, 2015): uno tecnológico, relacionado con conocimientos básicos y disposición de actualización; otro informacional, que refiere aspectos éticos sobre el correcto uso de la información; y finalmente el pedagógico, como el nivel de conocimiento en integración y aplicabilidad. Estas competencias deben ser abordadas de manera integral y estar más orientadas a saber ser y hacer con las tecnologías que a la posesión de conocimientos sobre ellas, pues se requiere que los docentes sean capaces de apropiarse, capacitarse y utilizarlas para una enseñanza constructiva, innovadora y de calidad (Flores-Lueg y Roig-Vila, 2016).

A nivel global, la Sociedad Internacional de Tecnología en la Educación (2017) propone un marco de competencias digitales para estudiantes, docentes y autoridades académicas. A los docentes se les requiere siete competencias: aprendiz, líder, ciudadano, colaborador, diseñador, facilitador y analista. En el ámbito internacional, diversos países han expedido una serie de competencias tecnológicas; por ejemplo, en España, el Marco Europeo de Competencias Digital del Profesorado DigCompEdu (Redecker y Punie, 2017; Cabero-Almenara y Palacios-Rodríguez, 2020; European Comission, s.f.) se integra de seis competencias con seis niveles de dominio cada una: compromiso profesional, recursos digitales, pedagogía digital, evaluación y retroalimentación, empoderar a los estudiantes, y facilitar la competencias digital de los estudiantes.

Por su parte, el Ministerio de Educación de Chile (2006) establece cinco competencias digitales y cada una se compone de 16 estándares: pedagógica, social, técnicos, gestión y desarrollo profesional. El Ministerio de Educación Nacional (2013) de Colombia plantea cinco competencias digitales para el profesorado, cada una con tres niveles (explorador, integrador e innovador): tecnológica, comunicativa, pedagógica, de gestión e investigativa.

En México, a través de la Ley General de Educación de 2019, la Secretaría de Educación Pública (SEP, 2020) expidió la Agenda Digital Educativa, cuyo objetivo es construir una nueva educación digital; esta posee cinco ejes rectores: la formación, actualización y certificación docente en competencias digitales; crear una cultura tecnológica en el sistema educativo nacional; la construcción, acceso y uso de los recursos digitales para aprender y enseñar; el fortalecimiento y ampliación de la conectividad e infraestructura de las tecnologías de la información, comunicación, conocimiento y aprendizaje digitales; y desarrollar, innovar, ser creativo e investigar con tecnologías educativas.

De igual manera, durante la pandemia derivada por el SARS-CoV-2, el uso tecnológico docente (UTD) brindó los espacios en los que se pudo dar continuidad a los procesos de enseñanza y aprendizaje. Durante esta contingencia, se implementó la modalidad de enseñanza remota de emergencia, la cual fue temporal y requirió esfuerzo para la creación de nuevas prácticas para la enseñanza mediada con tecnologías por parte de profesores/as (Sáez-Delgado et al., 2022).

Desde la psicología, la teoría social cognitiva considera el uso tecnológico de un profesor como una interdependencia entre aspectos cognitivos, ambientales y comportamentales, los cuales están modificándose entre sí (Bandura, 1986); una propuesta novedosa de esta teoría es el concepto de autoeficacia tecnológica docente, que se puede definir como la habilidad autopercibida del sujeto para hacer un uso efectivo con tecnologías, y que puede llegar a cumplir sus propias expectativas y metas (Morales et al., 2015).

Con el objetivo de medir el UTD, se han diseñado escalas psicométricas. En Perú, Galindo et al. (2021) elaboraron un cuestionario de uso de TIC con 12 ítems tipo Likert dirigido a profesoras/res universitarios; su estructura es bidimensional: información y comunicación, y creación y seguridad. El instrumento completo tuvo una confiabilidad alta (α=.890) y se encontró que la mayoría de los docentes tienen un nivel de uso tecnológico de regular (n=52) a alto (n=48).

Estos resultados son similares a los encontrados en otros estudios, como el de Winter et al. (2021), quienes, en una población de profesores irlandeses, utilizaron una escala de autorreporte para medir la frecuencia de uso y las habilidades tecnológicas; los resultados indican que el nivel de habilidad sobre seis tipos de UTD (procesadores de texto, correo electrónico, software de presentaciones, computadora o monitores, proyectores y uso de multimedia) en su mayoría es alto, ya que tienen un dominio de avanzado a experto; sin embargo, esta investigación no midió la confiabilidad de la escala.

En su trabajo, Lobos et al. (2022) han medido cuatro tipos de conocimientos necesarios para ejercer la docencia exitosamente en Chile. La escala TPACK tiene 40 reactivos distribuidos en cuatro tipos de conocimiento: tecnológico pedagógico del contenido, el pedagógico, el del contenido y el de la tecnología, que obtienen una solución con una varianza explicada total de 62%. También, en Estonia, Taimalu y Luik (2019) validaron una escala que evalúa la integración tecnológica percibida de seis reactivos y obtuvieron un alpha de Cronbach aceptable (α=.686) empleando la encuesta de creencias docentes hacia el uso tecnológico de Park y Ertmer (2007), la cual tiene otras dimensiones relacionadas con el uso tecnológico, como las creencias pedagógicas, creencias hacia el uso tecnológico y autoeficacia hacia el uso tecnológico.

En Chile, Riquelme-Plaza et al. (2022) validaron el cuestionario de competencia digital docente, que tiene 54 reactivos distribuidos en cinco dimensiones: información y alfabetización informacional; comunicación y colaboración; creación de contenido digital; seguridad; y resolución de problemas. Durante su proceso de validación no se eliminó ningún ítem por tener un alpha de Cronbach alto (.979); se comprobaron cuatro dimensiones que fueron nombradas por los autores: mantenimiento, problemas, gestión de la información y creación digital; el análisis factorial confirmatorio señala índices de bondad de ajuste adecuados: X²=896.415, (164 gl); p=.000; GFI=.886; CFI=.737; RMSEA=.063 (Hu y Bentler, 1999).

Aslan y Zhu (2017) indagan el uso tecnológico en estudiantes turcos de educación y egresados; para ello, utilizaron una escala de integración de tecnologías en las prácticas de enseñanza; los docentes reportaron hacer uso de buscadores en línea para la búsqueda de información y emplear software para presentaciones. La investigación es interesante por emplear factores contextuales (barreras externas, cursos de tecnología y universidad), factores cognitivos como las competencias tecnológicas, competencias para integrar con tecnología, ansiedad hacia las computadoras, experiencias y conocimientos pedagógicos; de esta manera, la subescala de prácticas de enseñanza con TIC visualiza el uso de manera integral.

Por otro lado, Tuapanta et al. (2017) crearon un cuestionario para obtener información relacionada con la información y la comunicación en población de docentes universitarios en España; este dispuso de 77 reactivos tipo Likert y después de la validación se redujeron a 35 ítems y tres dimensiones (conocimientos, uso y aptitudes), que indican estadísticos de confiabilidad altos (α=.916). Si bien la reducción de la escala inicial fue uno de los aspectos positivos del estudio, para determinar que un instrumento cuenta con las características apropiadas para ser utilizado en un estudio, es necesario someter la estructura factorial encontrada en la investigación a análisis confirmatorios que constaten índices de bondad de ajuste.

En México, Ortega-Sánchez (2021) desarrolló una escala de uso tecnológico en alumnos universitarios, que fue elaborada con 20 reactivos y tres dimensiones; sin embargo, no se probó su confiabilidad ni se reportaron datos de que el instrumento haya sido sometido a un proceso de validación. En cuanto a los docentes de educación básica mexicanos, se diseñó una escala para evaluar las experiencias docentes del uso de tecnología educativa en la contingencia sanitaria por SARS-COV2 (García-Leal et al., 2021); los autores informan que la escala muestra fiabilidad estadística, pero no indican el valor de la prueba estadística utilizada para determinarla ni señalan el proceso de validación psicométrica realizado.

Otras escalas a nivel nacional son la de Arras-Vota et al. (2021), quienes pilotearon una escala tipo Likert que mide la percepción del propio dominio para el manejo de las TIC de profesores de una universidad. La escala total fue confiable al tener un índice de alpha de Cronbach de α= .81 en un tiempo, y de α= .82 en un segundo momento; no obstante, en el estudio no se reporta que la escala fuera sometida a un análisis factorial exploratorio o confirmatorio. También, Contreras (2019) creó y validó una escala tipo Likert que mide el uso de programas para el análisis de datos, la utilización de buscadores especializados y el empleo de recursos educativos. El instrumento de uso de TIC obtuvo una confiabilidad adecuada (α=.73), es unidimensional y posee cuatro reactivos; el estudio menciona haber sometido la escala a una validación factorial.

La revisión de la literatura previa hace evidente la presencia de escalas psicométricas para la evaluación del uso tecnológico; en su mayoría, son cuestionarios dirigidos a estudiantes y profesores de otros niveles educativos como la educación básica; es decir, el análisis de los antecedentes permitió distinguir la escasez de cuestionarios dirigidos a profesores universitarios; del mismo modo, menos escalas miden el uso tecnológico docente, y se enfocan más a la evaluación de otros constructos, como las competencias digitales, integración o infusión tecnológica.

Si bien en el estudio de Tuapanta et al. (2017) no se confirmó su estructura factorial, la escala es adecuada por tener validez de contenido y evaluar la variable de uso tecnológico docente de nivel superior, además de ser breve y tener una confiabilidad alta (α=.916); por ello, el objetivo de esta investigación es validar la sección de uso tecnológico en población de profesores universitarios mexicanos, así como sus propiedades psicométricas a través de un análisis factorial confirmatorio y sus índices de bondad de ajuste de la estructura resultante. De este modo, se plantea la siguiente pregunta de investigación ¿la escala de uso tecnológico es válida y confiable para medir el UTD en docentes del nivel superior mexicanos?

La validación de la escala de Tuapanta et al. (2017) es necesaria de manera teórica, pues existen pocos cuestionarios que miden el UTD en el nivel superior a escala global, así como en el contexto mexicano. Con ello se contribuirá al diagnóstico del nivel de uso tecnológico de profesores universitarios mexicanos; de igual forma, esta investigación es necesaria en un sentido práctico, pues se busca obtener un instrumento válido, confiable y breve que pueda servir para evaluaciones o diagnósticos eficaces que agilicen intervenciones o capacitaciones de UTD.

Método

Diseño de la investigación

El estudio tiene un enfoque cuantitativo, es de tipo no experimental, exploratorio-descriptivo y alcance transversal.

Participantes

La muestra se conformó de 69 profesores(as) universitarios, de ellos 42% eran mujeres y 58%, hombres; la edad media se situó en 50 años y tuvo un rango de 27 a 76 años; la mayoría de profesores(as) poseen doctorado en un 42%, el 38%, maestría, el 10%, posdoctorado, el 7%, licenciatura y el 1%, diplomado; los docentes pertenecen a ocho universidades situadas al noroeste de México, públicas y privadas, así como generales y tecnológicas.

Instrumento de medición

Para evaluar el UTD se adaptó la escala de uso de TIC en docentes universitarios de Tuapanta et al. (2017), que es unifactorial y posee 11 reactivos tipo Likert y cuatro opciones de respuesta (totalmente en desacuerdo, en desacuerdo, de acuerdo y totalmente de acuerdo); los autores utilizaron un muestreo estratificado en siete facultades distintas en su estudio de validación.

Procedimiento de recolección de datos

Para la recolección de datos, enviamos correos de invitación a profesores universitarios para solicitar su participación voluntaria; mediante Google Forms, les brindamos los objetivos de la investigación y el tratamiento confidencial de los datos, y con base en las recomendaciones de la American Educational Research Association (2011), les pedimos el consentimiento informado y les proporcionamos el cuestionario.

Análisis de datos

El conjunto de datos se analizó en el programa JASP 0.16.3; en primera instancia llevamos a cabo un análisis factorial exploratorio y, posteriormente, un análisis factorial confirmatorio. Para el procedimiento del primero, utilizamos el método de máxima verosimilitud (Mavrou, 2015) debido a la ausencia de datos atípicos y a que encontramos valores normales (véase tabla 1) en los índices de asimetría y curtosis (Pardo y Ruiz, 2005; Lloret-Segura et al., 2014). De las técnicas de rotación oblicuas, recurrimos a la de Oblimin directo en virtud de una relación entre los factores, así como una asociación conceptual entre los reactivos (Mavrou, 2015). Luego de este análisis, examinamos el modelo de acuerdo con la estructura factorial resultante del análisis factorial exploratorio para después obtener el índice de consistencia interna a través del alfa de Cronbach (Cortina, 1993).

Aspectos éticos

El proyecto cuenta con la aprobación del Comité Institucional de Ética en Investigación del Instituto Tecnológico de Sonora bajo el dictamen 206 y el tratamiento confidencial de los datos se basa en los recomendados por la American Educational Research Association (Linn, 2011).

Resultados

La validación psicométrica comenzó analizando los 11 reactivos iniciales que componen la escala (Tuapanta et al., 2017) y generó estadística descriptiva con medidas de tendencia central (véase tabla 1). Examinando los rangos, confirmamos que todas las opciones de respuesta tuvieron al menos una frecuencia, pero, al analizar la distribución de respuestas por reactivo, constatamos que la mayoría no poseen direccionalidad (Mishra et al., 2019); ahora bien, corrimos pruebas de normalidad a través de los índices de asimetría y curtosis, que reportaron valores por debajo de ± 2.000. Realizamos también una prueba de Shapiro-Wilk, y obtuvimos una p significativa para cada reactivo (p=< .001); de este modo, la totalidad de los reactivos fueron incluidos en el siguiente paso de la validación (Mishra et al., 2019): el análisis factorial exploratorio.

Tabla 1. Estadísticos de tendencia central y pruebas de normalidad de los reactivos

|

Ítems |

Media |

Desv. est. |

Asimetría |

Curtosis |

Shapiro-Wilk |

α si se elimina |

|

Ítem١ |

3.397 |

.775 |

-1.030 |

.150 |

.742 |

.821 |

|

Ítem 2 |

3.559 |

.720 |

-1.570 |

.1.803 |

.651 |

.812 |

|

Ítem 3 |

2.088 |

.989 |

.488 |

-.812 |

.849 |

.812 |

|

Ítem 4 |

2.647 |

1.033 |

-.157 |

-1.112 |

.871 |

.822 |

|

Ítem 5 |

1.838 |

.891 |

.719 |

-.448 |

.809 |

.836 |

|

Ítem 6 |

2.544 |

1.028 |

-.164 |

-1.090 |

.869 |

.813 |

|

Ítem 7 |

2.691 |

.902 |

-.346 |

-.555 |

.866 |

.797 |

|

Ítem 8 |

2.426 |

.869 |

.303 |

-.526 |

.861 |

.812 |

|

Ítem 9 |

3.294 |

.963 |

-1.146 |

.156 |

.730 |

.801 |

|

Ítem 10 |

1.838 |

1.060 |

1.031 |

-.228 |

.748 |

.783 |

|

Ítem 11 |

2.824 |

.945 |

-0.181 |

-1.019 |

.859 |

.784 |

Debido a que la totalidad de ítems cumplió con condiciones de normalidad, optamos por utilizar pruebas paramétricas; analizamos las correlaciones de momento R de Pearson entre los reactivos y obtuvimos relaciones bajas, como .04, a moderadas, como .52 (Schober et al., 2018), por lo que decidimos emplear una rotación oblicua (véase tabla 2).

Tabla 2. Correlaciones R de Pearson de escala de uso tecnológico docente

|

Ítem |

|||||||||||

|

Ítem |

1 |

2 |

3 |

4 |

5 |

6 |

7 |

8 |

9 |

10 |

11 |

|

1 |

— |

||||||||||

|

2 |

0.12 |

— |

|||||||||

|

3 |

0.32** |

0.39** |

— |

||||||||

|

4 |

0.08 |

0.36** |

0.47** |

— |

|||||||

|

5 |

0.12 |

0.31** |

0.10 |

0.04 |

— |

||||||

|

6 |

0.12 |

0.19 |

0.30* |

0.28* |

0.01 |

— |

|||||

|

7 |

0.37** |

0.30* |

0.24* |

0.23* |

0.18 |

0.35** |

— |

||||

|

8 |

0.22 |

0.14 |

0.18 |

0.04 |

0.04 |

0.44** |

0.30* |

— |

|||

|

9 |

0.26* |

0.24* |

0.18 |

0.17 |

0.14 |

0.33** |

0.52** |

0.40** |

— |

||

|

10 |

0.30* |

0.38** |

0.30* |

0.31** |

0.20 |

0.31** |

0.61** |

0.49** |

0.63** |

— |

|

|

11 |

0.30* |

0.39** |

0.43** |

0.27* |

0.29 |

0.40** |

0.53** |

0.53** |

0.51** |

0.74** |

— |

Nota: *= correlación de significancia .05; **= correlación de significancia .01.

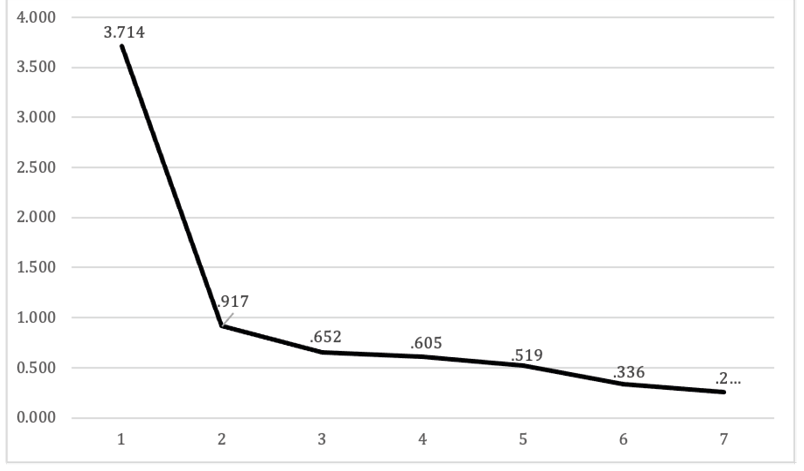

En un siguiente paso, sometimos la escala de uso de TIC a un análisis factorial exploratorio (Taherdoost et al., 2022), el cual alcanzó KMO de .80; la prueba de esfericidad de Bartlett generó una X² de 247.57 con 55 grados de libertad y una p de <.01. El resultado arroja una estructura unidimensional y los ítems 1, 4 y 5 fueron eliminados por tener lambdas o pesos factoriales por debajo de .400; luego de la eliminación de los reactivos, contamos con una varianza explicada del 33.6%.

Tabla 3. Pesos factoriales por reactivo de la escala de uso tecnológico docente universitario

|

Núm. |

Reactivos |

Est. Std |

|

1 |

Utilizo diferentes estrategias metodológicas con TIC (webquest, trabajo cooperativo, grupos de discusión, caza del tesoro) para el aprendizaje de mis alumnos |

.396 |

|

2 |

Doy atención a estudiantes mediante herramientas de tutoría virtual (Skype, Microsoft Teams, Meet Google) |

.478 |

|

3 |

Utilizo las TIC para evaluar a los alumnos (Excel, Microsoft Teams) |

.491 |

|

4 |

Utilizo los recursos de apoyo virtuales a docentes que proporciona la institución |

.394 |

|

5 |

Utilizo herramientas de software libre |

.258 |

|

6 |

Uso o publico contenidos digitales en el aula virtual (producción científica, materiales didácticos, presentaciones) |

.498 |

|

7 |

He participado e impulsado la realización de proyectos de innovación educativa con TIC en los últimos cinco años |

.682 |

|

8 |

Creo y mantengo una lista de sitios web relevantes |

.540 |

|

9 |

Participo en grupos de innovación e investigación sobre docente con TIC |

.652 |

|

10 |

Difundo a los alumnos mi experiencia con las TIC |

.842 |

|

11 |

Investigo y aplico sobre las posibilidades que me ofrecen las TIC para enriquecer mi práctica docente |

.845 |

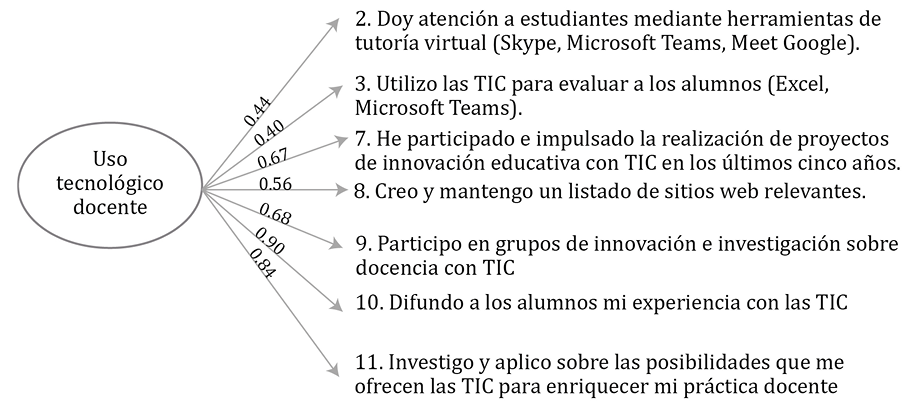

A continuación, los ocho reactivos restantes se sometieron a un análisis factorial confirmatorio; en este paso, eliminamos el reactivo 6 para reducir la posibilidad de factores no observados, ya que, al analizar las covarianzas de los residuales, encontramos disturbios en el ítem 6 con el 10 (mod. ind.= 5.292) y el 8 (mod. ind.= 4.224) (véase figura 1).

Figura 1. Gráfico oblicuo del análisis factorial confirmatorio.

Para la escala final (véase figura 2), obtuvimos índices de bondad de ajuste adecuados (Hu y Bentler, 1999) X²=26.885, (20 gl); p=.139; NFI=.873; CFI=.963; RMSEA=.071; SRMR= .060. Finalmente, procedimos a calcular la confiabilidad a través del alpha de Cronbach, y establecimos parámetros adecuados (α=.831) basados en Cortina (1993) y Hair et al. (2004).

Figura 2. Análisis factorial confirmatorio de uso de tecnologías en docentes universitarios.

Discusión

El objetivo de esta investigación se cumplió, ya que la escala inicial se sometió a un proceso de validación en el que comprobamos los índices de bondad de ajuste del modelo mediante pruebas descriptivas, de normalidad, correlación, así como análisis factoriales exploratorio y confirmatorio. Obtuvimos parámetros aceptables, lo que indica que la escala es válida y confiable para evaluar el UTD de nivel superior mexicanos.

Los profesores(as) participantes en este estudio obtuvieron una media general de 2.6; dado que el puntaje máximo es 4 y el mínimo 1, se tiene que los docentes encuestados poseen un nivel de uso medio tecnológico en sus procesos de enseñanza. Estos resultados coinciden tanto con los encontrados en estudios sobre educación media superior, los cuales orientan su uso a planificar sus clases y calificar al alumnado (Roney, 2015), como con los reportados en profesores universitarios (Galindo et al., 2021).

La estadística descriptiva por reactivo señala que los dos principales usos que los docentes realizan en el proceso de enseñanza con su alumnado son el empleo de diferentes estrategias metodológicas con TIC para el aprendizaje de los alumnos –como el trabajo cooperativo, grupos de discusión, entre otros– y brindar atención a los estudiantes mediante herramientas de tutoría virtual como Skype, Teams o Meet. Estos resultados son similares a los reportados en otras investigaciones (Mbugua et al., 2015; Roney, 2015; Umar y Hassan, 2015) en las cuales el uso tecnológico se centraba en la preparación de los materiales didácticos y en el manejo de las TIC dentro de clases.

A través de las medidas de tendencia central, encontramos que las actividades que los profesores menos ejecutan en esta muestra se relacionan con el uso de software libre y la difusión de la experiencia personal docente con los alumnos. Así, recomendamos, en un sentido institucional, integrar herramientas de libre acceso, pues se ahorrarían costos por compras de licencia de software y serían más accesibles para los alumnos. Por otro lado, la comunicación de la experiencia utilizando software de los profesores puede solucionar problemas técnicos que los alumnos enfrentan, además de agilizar procesos educativos.

El nivel de confiabilidad reportado por el alpha de Cronbach revela ser alto (α= .831), pero está por debajo (α=.916) de los obtenidos en el estudio del que procede la escala (Tuapanta et al., 2017); esto puede deberse a que los docentes que participaron en este último utilizaron las tecnologías para otras etapas del proceso enseñanza-aprendizaje, o bien, a que los procedimientos empleados por docentes hayan sido actualizados en la fecha de realización del estudio.

Respecto a variables similares al UTD, la integración tecnológica del profesor ha sido de .85 a .91, por lo que la escala validada en nuestro estudio se acerca a los estándares encontrados por Aslan y Zhu (2017); esto puede deberse a que la escala tiene otra estructura factorial y sus últimos tres reactivos abordan tareas simuladas para tres fines distintos, aspecto que puede contribuir a la elevación de la confiabilidad de la escala.

Por otro lado, la competencia digital docente es otra variable similar al UTD. En validaciones anteriores (Riquelme-Plaza et al., 2022) ha obtenido mayor fiabilidad α=.979, pero menores índices de bondad de ajuste: X²=896.415, (164 gl); p=.000; GFI=.886; CFI=.737; RMSEA=.063, en relación con los obtenidos en nuestra investigación: X²=26.885, (20 gl); p=.139; NFI=.873; CFI=.963; RMSEA=.071; SRMR= .060. Cabe señalar que el estudio de Riquelme-Plaza et al. (2022) no alcanzó significancia poblacional (p=.000), la cual se logra con datos mayores de .05 a diferencia de la validación realizada (p=.139), que obtuvo mejores índices de bondad de ajuste.

En cuanto a la varianza explicada, esta es menor que la reportada por otro constructo similar, la escala TPACK (Lobos et al., 2022) logró el 62% de la varianza explicada; la bondad de ajuste en esta investigación cumplió con los parámetros adecuados. La escala propuesta por Aslan y Zhu (2017) muestra índices similares, pero con pequeñas diferencias, como el RMSEA, en cuya investigación ajusta de mejor manera y está sujeto al número de indicadores y a las características poblacionales; puede ser mejor siempre y cuando la cantidad de población y número de reactivos aumenten.

Las aportaciones metodológicas de nuestra investigación es la adaptación y validación de la escala de uso tecnológico de profesores universitarios mexicanos, la cual obtuvo varianza explicada y confiabilidad adecuadas, así como índices de bondad de ajuste altos, en el margen de las escalas de UTD, además de constructos como integración tecnológica docente y las competencias digitales del profesorado. La estadística descriptiva utilizada en este estudio permitió diagnosticar los niveles de UTD de profesores universitarios mexicanos, e incrementar el conocimiento respecto a este tema.

En un sentido práctico, las aportaciones de nuestro trabajo residen en que el instrumento, por sus características, puede ser utilizado en contextos de capacitación o intervenciones orientadas al UTD y, con una estructura reducida a la escala original, permite hacer evaluaciones de manera más rápida, válida y confiable.

Los resultados de esta investigación pudieran ser útiles para el reforzamiento de estrategias planteadas para las instituciones de educación superior, como lo hace la Agenda Digital Educativa (SEP, 2020) con sus cinco ejes rectores, porque aspectos como la utilización de herramientas de tutoría virtual y de diferentes estrategias didácticas indicarían que el primer eje (“formación, actualización y certificación docente en competencias digitales”) está desarrollándose. Por otro lado, el compartir experiencias recurriendo a tecnologías pudiera crear y fortalecer una cultura tecnológica en el sistema educativo nacional, como lo marca el eje dos de la Agenda Digital Educativa (SEP, 2020). Además, el desarrollo de capacitaciones y de planeaciones que usen software libre pudiera contribuir al quinto eje: “desarrollar, innovar, ser creativo e investigar con tecnologías educativas”.

Alcances, limitaciones e investigaciones futuras

Una limitación de este estudio es la muestra reducida de profesores; sin embargo, el análisis factorial confirmatorio reveló significancia poblacional, dato que se encuentra en disposición de los ítems y la cantidad de profesores encuestados; por ello, para investigaciones futuras, recomendamos muestras más grandes, lo cual permitiría obtener mejores índices de ajuste, así como muestras recolectadas de diferentes zonas geográficas de México. También sería útil emplear el instrumento para la medición del uso antes y después de la pandemia, de esta manera se puede determinar el impacto que tuvo la contingencia sanitaria en el uso de tecnologías en los profesores universitarios, así como comparar muestras de profesores/ras de diferente nivel: educación básica, secundaria, media superior, superior y posgrado.

Referencias bibliográficas

American Educational Research Association (2011). Code of ethics: American Educational Research Association approved by the AERA Council February 2011. Educational Researcher, vol. 40, núm. 3, pp. 145-156. https://doi.org/10.3102/0013189X11410403

Arras-Vota, A., Bordas-Beltrán, J., Porras-Flores, D. y Diez, M. (2021). Evolución en el uso de las tecnologías de la información y comunicación (TIC) y competencias de los docentes de la Universidad Autónoma de Chihuahua (México) durante la pandemia. Formación Universitaria, vol. 14, núm. 6, pp. 183-192. http://dx.doi.org/10.4067/S0718-50062021000600183

Aslan, A. y Zhu, C. (2017). Investigating variables predicting Turkish pre‐service teachers’ integration of ICT into teaching practices. British Journal of Educational Technology, vol. 48, núm. 2, pp. 552-570.

Bandura, A. (1986). Social foundations of thought and action: A social cognitive theory. Prentice-Hall.

Cabero Almenara, J., Barroso Osuna, J., Rodríguez Gallego, M. y Palacios Rodríguez, A. (2020). La competencia digital docente. El caso de las universidades andaluzas. Aula Abierta, vol. 49, núm. 8, pp. 363-371. https://doi.org/10.17811/rifie.49.3.2020

Cabero-Almenara, J. y Palacios-Rodríguez, A. (2020). Marco Europeo de Competencia Digital Docente “DigCompEdu” y cuestionario “DigCompEdu Check-In”. EDMETIC, Revista de Educación Mediática y TIC, vol. 9, núm. 1, pp. 213-234. https://doi.org/10.21071/edmetic.v9i1.12462

Contreras, C. (2019). Investigación de las competencias digitales y uso de tecnologías en la práctica del profesor universitario. En R. Roig-Vila (ed.). Investigación e innovación en la enseñanza superior, nuevos contextos, nuevas ideas (pp. 104-112). https://rua.ua.es/dspace/bitstream/10045/98731/1/Investigacion-e-innovacion-en-la-ES.pdf#page=117

Cortina, J. (1993). What is coefficient alpha? An examination of theory and applications. Journal of Applied Psychology, vol. 78, núm. 1, p. 98. https://psycnet.apa.org/doi/10.1037/0021-9010.78.1.98

European Commission (s.f.). Digital Competence Framework for Educators (DigCompEdu). https://ec.europa.eu/jrc/sites/jrcsh/files/digcompedu_leaflet_es-nov2017pdf.pdf

Flores-Lueg, C. y Vila, R. R. (2016). Diseño y validación de una escala de autoevaluación de competencias digitales para estudiantes de pedagogía. Píxel-Bit. Revista de Medios y Educación, núm. 48, pp. 209-224.

Fonseca, C. (2005). Moving beyond the digital gap: Investing in the young to create newearning and socio-economic opportunities. En Harnessing the potential of ICT in education. United Nations ICT Task Force. http://www.fod.ac.cr/pdf/publicaciones/articulos/2005/MovingbehondthedigitalgapUNICTTFbook.pdf

Galindo, W., Samaniego, E., Quiñonez, G. y Ayala, A. (2021). Uso de las TIC en docentes universitarios de la región central del Perú. Ciencia Latina Revista Científica Multidisciplinar, vol. 5, núm. 4, pp. 4985-5006. https://doi.org/10.37811/cl_rcm.v5i4.671

García-Leal, M., Medrano-Rodríguez, H., Vázquez-Acevedo, J., Romero-Rojas, J. y Berrún-Castañón, L. (2021). Experiencias docentes del uso de la tecnología educativa en el marco de la pandemia por COVID-19. Revista Información Científica, vol. 100, núm. 2). http://scielo.sld.cu/scielo.php?script=sci_arttext&pid=S1028-99332021000200015

Hair, J., Anderson, R., Tatham, R. y Black, W. (2004). Análisis multivariante. https://documat.unirioja.es/servlet/libro?codigo=320227

Hu, L. y Bentler, P. (1999). Cutoff criteria for fit indexes in covariance structure analysis: Conventional criteria versus new alternatives. Structural equation modeling: A multidisciplinary journal, vol. 6, núm. 1, pp. 1-55. https://doi.org/10.1080/10705519909540118

Linn, R. (2011). The standards for educational and psychological testing: Guidance in test development. En Handbook of test development (pp. 41-52). Routledge. https://jeromedelisle.org/assets/

Lloret-Segura, S., Ferreres-Traver, A., Hernández-Baeza, A. y Tomás-Marco, I. (2014). El análisis factorial exploratorio de los ítems: una guía práctica, revisada y actualizada. Anales de Psicología, vol. 3, pp. 1151-1169. http://doi.org/10.6018/analesps.30.3.199361

Lobos, K., Cobo-Rendón, R., Guzmán, E. y Bruna, C. (2022). Adaptación y validación de dos cuestionarios sobre implementación de la tecnología en la docencia universitaria. Formación Universitaria, vol. 15, núm. 5, pp. 1-14. http://dx.doi.org/10.4067/S0718-50062022000500001

Mavrou, I. (2015). Análisis factorial exploratorio. Revista Nebrija de Lingüística Aplicada a la Enseñanza de Lenguas, núm. 19, pp. 71-80. https://doi.org/10.26378/rnlael019283

Mbugua, S., Kiboss, J. y Tanui, E. (2015). Influence of integration of information communication technology in teaching on students’ academic performance. Journal of Education and Practice, vol. 6, núm. 24, pp. 7-13. http://hdl.handle.net/123456789/4486

Ministerio de Educación de Chile (2006). Estándares en tecnología de la información y la comunicación para la formación inicial docente.

Ministerio de Educación Nacional (2013). Competencias TIC para el desarrollo profesional docente. https://www.mineducacion.gov.co/1759/articles- 339097_archivo_pdf_competencias_tic.pdf

Mishra P., Pandey C., Singh U., Gupta A., Sahu C. y Keshri A. (2019). Descriptive statistics and normality tests for statistical data. Ann Card Anaesthm, vol. 22, núm. 1, pp. 67-72. https://doi.org/10.4103/aca.ACA_157_18

Morales, K. F., Casarín, A. V. y Salas, L. M. (2015). Apropiación tecnológica: una visión desde los modelos y las teorías que la explican. Perspectiva Educacional, Formación de Profesores, vol. 54, núm. 2, pp. 109-125.

Organización de Estados Iberoamericanos para la Educación, la Ciencia y la Cultura (2008). Metas educativas 2021 la educación que queremos para la generación de los bicentenarios. Madrid, España.

Organización de las Naciones Unidas para la Educación, la Ciencia y la Cultura (2019). Aprovechar las TIC para alcanzar las metas de Educación 2030. https://es.unesco.org/themes/tic-educacion/weidong#:~:text=%E2%80%9CAprovechar%20las%20TIC%20para%20alcanz ar,4%20de%20aqu%C3%AD%20a%202030

Organización de las Naciones Unidas para la Educación, la Ciencia y la Cultura (2016). Competencias y estándares TIC desde la dimensión pedagógica: una perspectiva desde los niveles de apropiación de las TIC en la práctica educativa docente. https://unesdoc.unesco.org/ark:/48223/pf0000259508

Organización de las Naciones Unidas para la Educación, la Ciencia y la Cultura (2008). Medición de las tecnologías de la información y la comunicación (TIC) en educación–manual del usuario. Documento técnico 2. Instituto de Estadística de la Unesco. http://uis.unesco.org/sites/default/files/documents/guide-to-measuring-information-and-communication-technologies-ict-in-education-sp.pdf

Ortega-Sánchez, R. (2021). Uso de herramientas tecnológicas en tiempos de COVID-19. Revista Tecnológica-Educativa Docentes 2.0, vol. 12, núm. 1, pp. 31-39. https://doi.org/10.37843/rted.v1i1.223

Pardo, A. y Ruiz, M. (2005). Análisis de datos con SPSS 13 Base. McGraw-Hill.

Park, S. y Ertmer, P. (2007). Impact of problem-based learning (PBL) on teachers’ beliefs regarding technology use. Journal of Research on Technology in Education, vol. 40, núm. 2. https://doi.org/10.1080/15391523.2007.10782507

Rangel, A. (2015). Competencias docentes digitales: propuesta de un perfil. Píxel-Bit. Revista de Medios y Educación, vol. 46, pp. 235-248.

Redecker, C. y Punie, Y. (2017). Digital Competence of Educators DigCompEdu. Publications Office of the European Union. https://ideas.repec.org/p/ipt/iptwpa/jrc107466.html

Riquelme-Plaza, I., Cabero-Almenara, J. y Marín-Díaz, V. (2022). Validación del cuestionario de competencia digital docente en profesorado universitario chileno. Revista Electrónica Educare, vol. 26, núm. 1, pp. 165-179. http://dx.doi.org/10.15359/ree.26-1.9

Roney, L. (2015). Technology use, technological self-efficacy and general self-efficacy among undergraduate nursing faculty. Southern Connecticut State University. https://www-proquest-com.itson.idm.oclc.org/openview/bb8ab2cfa1c040669fdccb99f944b2f9/1?cbl=18750&parentSessionId=6oGUhf1pxOY9k1KeudOUlnZglfWbClgeaRcbXoHsgU4%3D&pq-origsite=gscholar&accountid=31361

Sáez-Delgado, F., López-Angulo, Y., Mella-Norambuena, J. y Casanova, D. (2022). Prácticas docentes para promover la autorregulación del aprendizaje durante la pandemia COVID-19: escalas de medición y modelo predictivo. Formación Universitaria, vol. 15, núm. 1, pp. 95-104.

Schober, P., Boer, C. y Schwarte, L. (2018). Correlation coefficients: appropriate use and interpretation. Anesthesia & Analgesia, vol. 126, núm. 5, pp. 1763-1768. https://doi.org/10.1213/ANE.0000000000002864

Secretaría de Educación Pública (2020). Agenda Digital Educativa: ADE.mx. https://infosen.senado.gob.mx/sgsp/gaceta/64/2/2020-02-05-1/assets/documentos/Agenda_Digital_Educacion.pdfa

Sociedad Internacional de Tecnología en la Educación (2017). ISTE standards for educators. https://id.iste.org/trackedlink?link=4219

Taherdoost, H., Sahibuddin, S. y Jalaliyoon, N. (2022). Exploratory factor analysis; concepts and theory. Advances in Applied and Pure Mathematics, vol. 27, pp. 375-382.

Taimalu, M. y Luik, P. (2019). The impact of beliefs and knowledge on the integration of technology among teacher educators: A path analysis. Teaching and Teacher Education, vol. 79, pp. 101-110. https://doi.org/10.1016/j.tate.2018.12.012

Tuapanta, J., Duque, M. y Mena, A. (2017). Alfa de Cronbach para validar un cuestionario de uso de TIC en docentes universitarios. Revista mktDescubre-ESPOCH FADE, núm. 10, pp. 37-48. http://dspace.espoch.edu.ec/handle/123456789/9807

Umar, I. y Hassan, A. (2015). Malaysian teachers’ levels of ICT integration and its perceived impact on teaching and learning. Procedia-Social and Behavioral Sciences, vol. 197. https://doi.org/10.1016/j.sbspro.2015.07.586

Winter, E., Costello, A., O’Brien, M. y Hickey, G. (2021). Teachers’ use of technology and the impact of COVID-19. Irish Educational Studies, vol. 40, núm. 2, pp. 235-246. https://doi.org/10.1080/03323315.2021.1916559

World Economic Forum (2016). The future of jobs: employment, skills and workforce strategy for the fourth industrial revolution. Global Challenge Insight Report. http://hdl.voced.edu.au/10707/393272